Содержание

K8s

Основные понятия

https://kube.academy/courses/kubernetes-core-concepts-part-1/lessons/kubernetes-fundamentals

Принципы Cloud Native:

- Контейнеризация (докер)

- Динамическое управление – Кубернетис

- Ориентация на микросервисы – Кубернетис

В Кубернетисе мы задаём желаемое состояние (desired state), т. е., система сама подстраивается и предпринимает конкретные действия, чтобы этого достичь.

Pod

Pods – один или несколько контейнеров. Все контейнеры в одном поде:

- запускаются на одном хосте

- взаимодействуют друг с другом через localhost

- имеют одинаковый доступ к томам

Иными словами, pod – это аналог сервера или виртуальной машины. Это помогает определиться в каждом случае, запускать ли 2 контейнера в 1 поде или в разных, планирование такое же, как действовать в случае с ВМ.

Sidecars – сопутствующие контейнеры в одном поде с основным. К примеру, есть контейнер веб-сервера, и туда при запуске копируется контент. Чтобы поправить какую-то ошибку в контенте, нужно перезапускать контейнер. Вместо этого в под помещается другой контейнер, который копирует контент со стороннего ресурса (например, с git), и кладёт на общий том (единый в рамках одного пода), а веб-сервер просто отображает содержимое.

apiVersion: v1 kind: Pod (с чем работаем) metadata: name: mypod1 (уникальный идентификатор) labels: app: blog spec: (всё в разделе spec характерно для выбранного типа, в данном случае пода) containters: - name: nginx Image: nginx:1.13.1 - name: www-syncer Image: syncer:1.2

Как запустить эту конструкцию?

# Предпочтительный путь (declarative): kubectl apply –f [file | dir | url] # imperative: kubectl create # создать новый ресурс из файла kubectl replace # обновить существующий ресурс из файла kubectl edit # обновить существующий ресурс, используя редактор kubectl patch # обновить существующий ресурс слиянием code snippet

Binding

Чтобы жёстко привязать под к ноде, используется spec.nodeName. Если под уже существует, то можно изменить имя ноды в свойствах пода или создать объект kind: Binding.

apiVersion: v1 kind: Binding metadata: name: nginx target: apiVersion: v1 kind: Node name: node02

, а потом послать запрос POST в API в формате json, что имитирует работу планировщика.

# пример $ curl --header "Content-Type:application/json" --request POST --data '{"apiVersion":"v1", "kind":"Binding" ...}' http://$SERVER/api/v1/namespaces/default/pods/$PODNAME/binding/

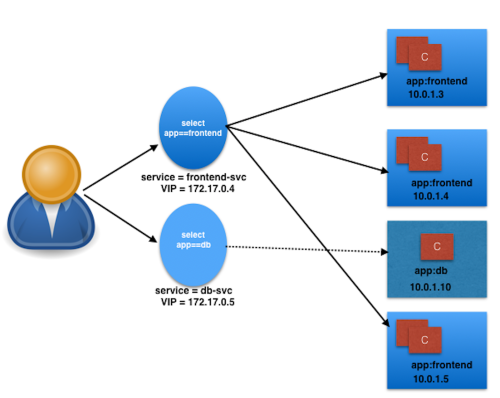

Service

Для сетевого доступа и балансировки существует тип объекта Service. Для определения целевых подов используются ярлыки (labels).

apiVersion: v1 kind: Service metadata: name: my-blog labels: app: blog spec: selector: app: blog ports: - protocol: TCP port: 80 (порт сервиса) targetPort: 80 (порт подов сервиса)

Вместо имен или IP-адресов подов используется селектор, работающий как запрос для поиска подходящих подов для доступа.

Deployment

А что, если нужно, к примеру, 20 одинаковых подов, чтобы справиться с нагрузкой? 20 одинаковых yml с одной различающейся строкой «name:»! Т. к. это явный идиотизм, существует более высокоуровневый объект Deployment, который занимается оркестровкой подов, создавая и убивая их по необходимости.

apiVersion: apps/v1 kind: Deployment metadata: name:my-blog spec: replicas: 3 (копий подов) selector: matchLabels: app: blog template: metadata: labels: app: blog spec: containers: - name: nginx Image: nginx:1.7.9 Ports: - containerPort: 80

В данном случае раздел template является фактически описанием пода, за исключением имени, т. к. подов может быть много и имена будут присваиваться автоматически.

Ярлыки (labels) выполняют как организационную, так и функциональную работу (как селекторы сервисов), они индексированы и по ним можно искать. Лучше не использовать составных ярлыков типа app: blog-frontend, потому что нет частичного или regexp-сравнения по ярлыкам. Гораздо лучше app: blog / tier: frontend. Также очень желательно иметь некий стандарт написания ярлыков в рамках кластера.

Документация:

https://docs.kubernetes.io

https://kubernetes.io/docs/reference

https://kubectl.docs.kubernetes.io

kubectl explain pods # встроенная справка по разным разделам, в данном случае о подах kubectl api-resources # список доступных типов ресурсов kubectl apply -f service.yaml # запустить сервис или деплой kubectl get service -l "app=blog" # проверить, что сервис создан kubectl get deployment -l "app=blog" # проверить, что деплой создан

Решение проблем

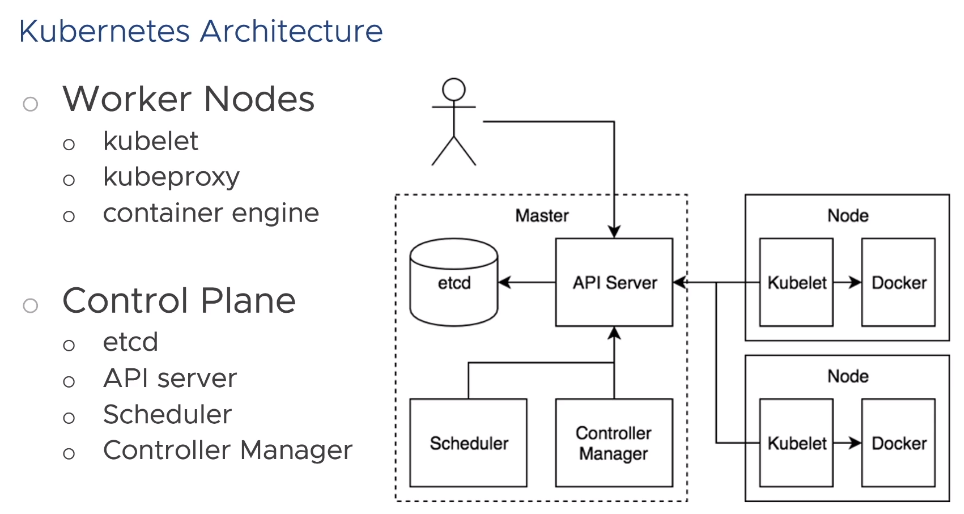

Ноды делятся на 2 типа – worker nodes и control plane. На рабочих ставится контейнерный движок (например, Докер), kubelet, взаимодействующий с докером, и kubeproxy. Control plane состоит из API, с которым взаимодействует админ. API работает с etcd – хранилищем конфигураций. Scheduler – определяет, где поды запускаются. Controller manager – управляет объектами (подами, сервисами и т. д.).

Kubectl get events [-w] # события кластера. По умолчанию хранит данные за час. [-w] – показ в реальном времени. Полезно при проблемах с cubectl apply. Kubectl describe pod gowebapp-3498323ff-348hf # описание объекта вместе с его событиями Kubectl get pods [–o wide] # список объектов, wide – более подробно. Kubectl logs gowebapp-3498323ff-348hf # смотреть логи. Добавить –c <container_name>, если под содержит больше 1 контейнера. Kubectl exec gowebapp-3498323ff-348hf – ls –l /opt/gowebapp # запустить команду. Добавить –c <container_name>, если под содержит больше 1 контейнера.

Управление развертыванием

Deployment создаёт промежуточную сущность ReplicaSets, которая уже создаёт поды. Соответственно, есть две стандартные стратегии развёртывания:

RollingUpdate - стратегия по умолчанию,когда старые поды постепенно замещаются новыми. К примеру, в deployment.yaml была заменена версия image. После применения обновлённого файла создаётся ещё одна ReplicaSet, там создаётся один под из нового образа (в этот момент общее число подов становится на один больше и трафик между ними балансируется, т. к. у них общие ярлыки). Если под создался успешно, гасится один под из старой реплики, и так далее, пока все поды не заменятся на новые в новой реплике. Старая пустая реплика удалится через некоторое время.

Recreate - сначала гасятся все поды, удаляется старая реплика, а затем создаётся новая и там разворачиваются поды. Это нужно для баз MySQL, т. к. недопустима балансировка между старыми и новыми версиями БД.

Также, имеются дополнительные стратегии, они не встроенные, но их можно выстраивать самостоятельно:

Canary - создаётся ещё один файл deployment, где в labels: указан дополнительный track: canary. В основном деплое указывается track: stable. Для canary указывается, например, одна реплика. После применения получается так, что трафик балансируется между всеми подами, т. е., часть трафика попадает на новую версию. Если всё нормально и нужно полностью перейти на новую версию, новый образ прописывается в stable deployment, а в canary кол-во реплик ставится 0.

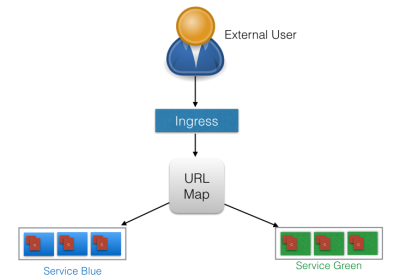

Blue/Green - популярно в облачной среде, где трафик по щелчку переключается со старой версии на новую. Так же, как и в Canary, создаётся второй деплой - в blue в labels: указан дополнительный color: blue, а в деплое green, соответственно, color: green. В то же самое время, нужно иметь два сервиса - blue и green, где в selector: указаны соответствующие ярлыки, чтобы иметь возможность тестирования деплоя green. Получается, что одновременно работает и прод, и тест, каждый со своим трафиком.

Когда тесты закончились и нужно ввести тестовый вариант (green) в прод, редактируется сервис, где меняется ярлык c color: blue на color: green. Если никто не жалуется и всё нормально, в деплое blue кол-во реплик меняется на 0.

В следующий раз тестовой средой будет уже blue, т. к. green перешёл в прод.

# Развёртывание можно приостанавливать и снова продолжать kubectl rollout [pause | resume] deployment <name> # Откат изменений (declarative, рекомендуется) - ред. деплой и применение kubectl apply -f deployment.yaml # Откат изменений (imperative) kubectl rollout undo deployment <name>

Сам объект Deployment имеет доп. опции, вот некоторые из них:

- progressDeadlineSeconds - макс. время развёртывания в секундах

- minReadySeconds - мин. время готовности пода в секундах без падения какого-либо из входящих в него контейнеров (станд. значение - 0)

- revisionHistoryLimit - кол-во хранимых реплик для возможности отката изменений (10)

- paused - приостановка развёртывания. Если true, то любые изменения в разделе spec не приведёт к развёртыванию.

Лабораторная (https://kube.academy/courses/kubernetes-core-concepts-part-2/lessons/lab-deployment-management).

- Сделали образ docker новой версии, внеся изменения в код, собрали, поставили тэг и залили в каталог (push)

- Для пробы отредактировали основной деплой на новый образ и через 1 сек. поставили развёртывание на паузу - получилось 3 пода: 1 новый и 2 старых. Describe deployment показал, что есть 2 реплики.

kubectl rollout resume deployment <name>- продолжили, потом проверили - все поды принадлежат новой реплике.- Теперь канареечный деплой. Создаётся соответствующий файл деплоя, где во все labels и matchLabels добавляется

track: canary. Образ, конечно, новый, реплика одна. - Канареечный деплой применяется. Теперь стало три реплики приложения, одна из которых канареечная, и трафик ходит между всеми, что можно видеть на странице приложения, обновляя её.

- Теперь, если создать доп. сервис для канареечного деплоя, где в раздел

selector:добавить ярлыкtrack: canaryи запустить этот сервис, то трафик пойдёт только на канареечный сервис, т. к. доступ там тот же, что и у прода. - Чтобы полностью перейти на новую версию в проде, надо обновить версию образа в прод. деплое, а в канареечном поставить

replicas: 0. Потом применить все .yaml в папке путёмkubectl apply -f ~/folder - Удалить канареечные сущности:

kubectl delete service canary,kubectl delete deployment canary.

Конфигурация подов и контейнеров

Проверки

Есть 2 встроенных типа проверок состояния контейнера:

- Liveness - запущен ли контейнер. При сбое он будет перезапущен согласно политике.

- Readiness - готов ли контейнер принимать запросы. При сбое под удаляется из сервиса, так что запросы на него приходить не будут.

Способы проверки (probe handlers):

- Exec - запуск команды, даёт код возврата, 0 - успешно.

- TCPSocket - TCP-проверка. Порт открыт и принимает соединения - успешно.

- HTTPGet - HTTP GET, коды 2xx-3xx - успешно.

Примеры применения проверок: Readiness probe - когда веб-процесс в контейнере начинает отвечать меньше заданного времени, чтобы при его инициализации не пускать туда трафик, во избежание тормозов на стороне юзера. Для JVM - Liveness probe для URL или для определённых строк в логах (я занят, не шлите на меня трафик). Контейнер может включить режим обслуживания, если он не прошёл Readiness probe.

О самих проверках нужно позаботиться на стороне контейнера/образа, не в K8s!

Настройки проверок:

- initialDelaySeconds - задержка запуска проверки после старта контейнера

- periodSeconds - частота проверок (10 сек)

- timeoutSeconds - тайм-аут при проверке (1 сек)

- successThreshold - кол-во успешных проверок для признания контейнера исправным (1)

- failureThreshold - кол-во неуспешных проверок для признания контейнера сбойным (3)

Пример

apiVersion: v1 kind: Pod metadata: labels: test: readiness name: exec-readiness spec: securityContext: runAsUser: 1000 containers: - name: readiness image: busybox args: - /bin/sh - -c - touch /tmp/healthy; sleep infinity readinessProbe: exec: command: - cat - /tmp/healthy initialDelaySeconds: 5 periodSeconds: 5

Пример, когда нужно отслеживать определённый текст на странице, а не просто её доступность.

livenessProbe: exec: command: - sh - -c - | curl -so - http://localhost:8080/actuator/health/f1_pwd_health |grep -q "UP" initialDelaySeconds: 60 timeoutSeconds: 5

https://github.com/kubernetes/kubernetes/issues/78436#issuecomment-1419446462

https://www.reddit.com/r/kubernetes/comments/a7gc2p/long_exec_probes/

Ресурсы

Указываются для каждого контейнера.

Процессор - это эквивалент 1 AWS vCPU / 1 GCP Core / 1 Azure vCore / 1 Hyperthread on Intel CPU w/Hyperthreading. Если в процентах, то 0.1 или 100m - это 10% (100 миллипроцессоров). Самое минимальное значение - 1m.

Память и хранилище - десятичные значения (K, M, G, T, P, E) и двоичные (Ki, Mi, Gi, Ti, Pi, Ei).

Требования к ресурсам (Resource requests) - нужно для более эффективного и понятного распределения по серверам кластера. Т. е., указание, сколько нужно контейнеру, чтобы быть размещённым на том или ином хосте, иначе либо контейнер не будет размещён на хосте с недостаточными ресурсами, либо будет тормозить. По умолчанию - 0.5 vCPU и 256 Mi памяти.

containers: - name: db image: mysql resources: requests: memory: "512Mi" cpu: "0.5"

Предел ресурсов (Resource limits) - чтобы контейнер не сожрал слишком много ресурсов и не завалил всю систему. При попытке превысить ресурсы CPU контейнер будет ограничиваться в потреблении (throttling), при превышении лимита памяти он будет убит и пересоздан. По умолчанию - 1 vCPU и 512 Mi памяти.

containers: - name: db image: mysql resources: limits: memory: "1Gi" cpu: "1"

Когда ноды кластера не имеют достаточно ресурсов для размещения доп. подов, планировщик не может выполнить требований деплоя и поды будут помечены как Pending, пока не призойдут какие-либо изменения ситуации для достижения желаемого состояния, например

- Будут добавлены новые хосты в кластер

- Будут пересмотрены требования к ресурсам в деплое

- Другие поды и деплои будут удалены или уменьшены в размере

- Кол-во желаемых подов будет уменьшено в текущем деплое

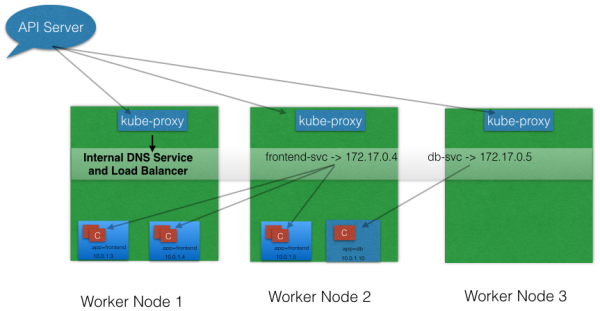

Сеть

Трафик в K8s можно поделить на 4 сегмента: внутри пода, между подами, между сервисом и подами, извне к кластеру.

Т. к. под всегда находится на одном хосте, то его внутренний трафик не идёт «по проводу». Внутри пода для связи контейнеров используется localhost, разделяют общий IP-адрес в рамках кластера - в целом, так же, как и в случае виртуальной машины.

У каждого пода есть свой уникальный маршрутизируемый IP-адрес в рамках внутренней виртуальной сети кластера. Также, есть подобие DNS-имени на базе metadata: name:. Внешние устройства напрямую к подам получить доступ не могут.

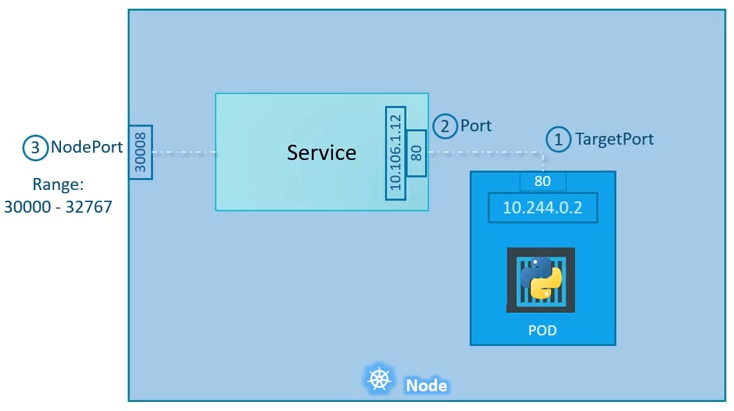

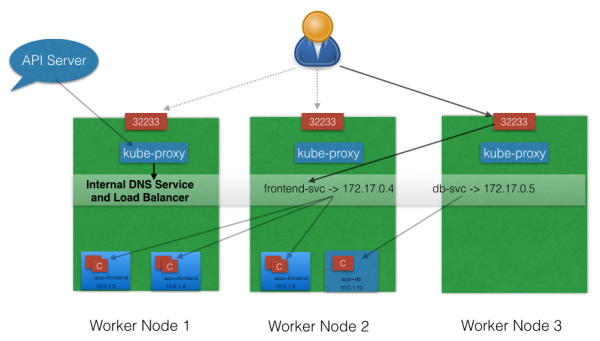

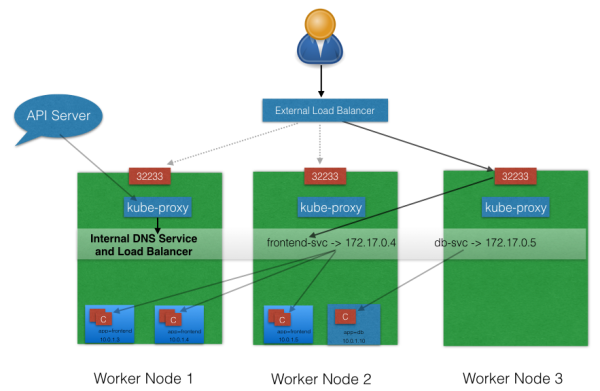

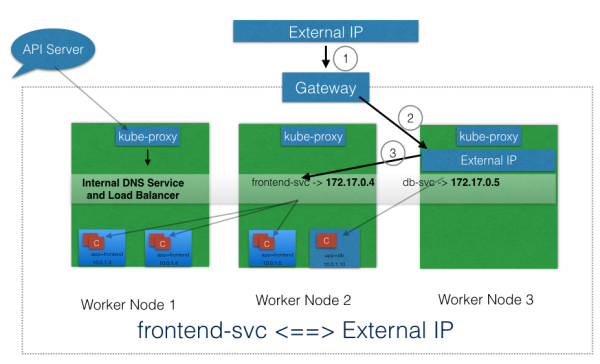

Сервис работает как NLB 4-го уровня. Есть 3 типа сервисов:

- ClusterIP - публикация внутри кластера, т. е., поды за сервисом публикуются для других подов в том же кластере. Внешнего доступа нет. Используется, например, для сервисов БД. Это стандартный тип сервиса, если не указано иначе.

- NodePort - публикация как порт на всех рабочих нодах. Т. е., попасть к сервису можно, обратившись на любую рабочую ноду кластера на указанный порт. Это не отменяет необходимости внешнего балансировщика, который уже будет балансировать сами ноды.

- LoadBalancer - создание и управление внешним балансировщиком, где NodePort используется для вхождения трафика, а ClusterIP для балансировки между подами. Есть разные плагины для разных реализаций внешнего балансировщика.

Ingress Controller - это NLB 7-го уровня. Ему, в отличие от NodePort, не нужно открывать кучу портов на нодах. Есть множество реализаций контроллера Ingress, такие, как Nginx, Contour, Traefik, Amazon ALB, Google Layer-7 Load Balancer. Запускается он как поды в кластере, опубликованные на NodePort, которые пробрасывают внешний трафик на ClusterIP сервисов. Для Ingress-контроллера нужно создать объект kind: Ingress.

https://kubernetes.io/docs/concepts/services-networking/ingress/

Организация ресурсов

Наивысший уровень изоляции сервисов - это разнесение их по разным кластерам - prod, qa, dev и т. п. Также это имеет смысл при каких-то требованиях безопасности или при географическом распределении датацентров. В этом случае имеются некоторые доп. усилия на управление.

Следующий - это namespace в рамках одного кластера. Каждый объект кластера входит в своё пространство, и в рамках этого пространства должен иметь уникальное имя. Это даёт возможность запускать один и тот же сервис в разных пространствах имён без риска перезаписать соседние настройки. Также это ограничивает внутрикластерные DNS-запросы, которые выглядят как поддомен - <service-name>.<namespace-name>.cluster.local. Если нужно подключиться к сервису в другом пространстве имён, необходимо использовать FQDN (<service-name>.<namespace-name>.cluster.local). Можно разграничивать права - одному можно дать namespace только на чтение, другому - полный доступ, а также namespaces задают квоты ресурсов. Хороший пример использования пространства имён - по одному на проект.

# Вывести пространства имён kubectl get namespaces # Вывести поды другого пространства kubectl get pods -n namespace-name

Ярлыки (labels) - могут быть привязаны почти к любому объекту в k8s, даже к нодам (кроме встроенных). Они необязательны, но выполняют также и функциональную роль - использование в селекторах и т. п. Необходимо вести список ярлыков и делать отчёты по ним, избегать составных ярлыков (лучше app: web tier: frontend, чем app: web-frontend). Также, нужна система именования ярлыков - такая, как если бы всё нужно было бы разместить в одном пространстве имён, пользуясь только ярлыками для организации ресурсов.

# ФИльтровать вывод по ярлыку kubectl get pods -l tier=frontend

kubectl знает, с каким кластером он работает, из файла ~/.kube/config. Там 3 секции - clusters:, где перечислены кластеры, contexts:, где соединяются сведения о кластерах и пользователях, и users: - пользователи. name: в clusters: - это просто локальное отображаемое имя. users: - там имя тоже просто для отображения локально. Если, положим, есть 3 кластера и во всех них одинаковый пользователь, то будет 3 записи в кластерах, 1 в пользователях и 3 в контекстах.

# добавить namespace в контекст конфига kubectl config set-context my-context --user poweruser --cluster cluster1 --namespace my-namespace # Переключиться на новый контекст kubectl config use-context my-context # см. какой контекст сейчас используется kubectl config current-context # все контексты kubectl config get-contexts # переключиться на другое пространство имён в текущем контексте kubectl config set-context $(kubectl config current-context) --namespace=another

https://kube.academy/courses/kubernetes-core-concepts-part-3/lessons/lab-resource-organization

# jsonpath - фильтр сырого вывода json. Ещё опции вывода - yaml, json, wide kubectl get deployment nginx -o jsonpath='{.status.availableReplicas}' # Перенаправить порт из пода (8080) на локальную машину (8000). Потом можно делать запросы, например, curl-ом - localhost:8000 kubectl port-forward <pod_id> 8000:8080

https://kubernetes.io/docs/reference/kubectl/jsonpath

Квота ресурсов для namespace задаётся объектом ResourceQuota.

apiVersion: v1 kind: ResourceQuota metadata: name: dev-quota namespace: dev spec: hard: pods: "10" requests.cpu: "4" requests.memory: 5Gi limits.cpu: "10" limits.memory: 10Gi

Stateful apps

Хранилище для таких приложений может быть разных типов. Работает на уровне пода, подобно хранилищу для виртуалки.

Особый тип хранилища - EmptyDir. Временный каталог, существует только когда под запущен. Нужен для организации общего каталога между контейнерами внутри пода.

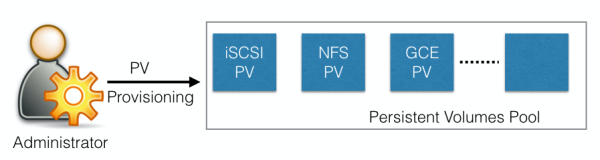

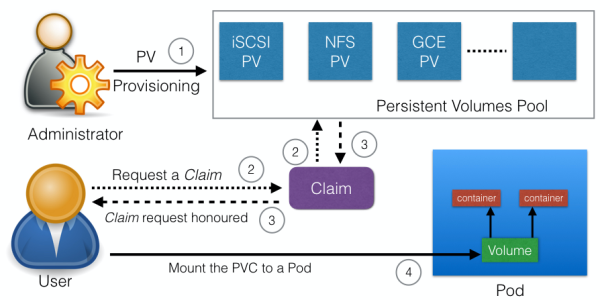

Persistent Volume - не зависит от времени жизни пода, кочует вместе с ним с хоста на хост. Есть опция hostPath, указывающая путь на ноде, но без крайней необходимости её лучше не применять.

Persistent Volume Claims (PVC) - запрос на организацию хранилища с заданными параметрами (размер, режим доступа и т. д.)

Хранилища могут быть созданы статически (руками), и динамически (по запросу к API провайдера типа Amazon EBS).

Для PVC создаётся объект kind: PersistentVolumeClaim - файлик с описанием (некий стандартизованный аналог служебной записки в ИТ-отдел на предоставление места на диске), а в spec: пода пишется раздел volumes:, который ссылается на соответствующий объект PVC, а в описании контейнеров пишется подраздел volumeMounts:, монтирующий нужные тома к нужным контейнерам. Если при применении файла PVC такое хранилище уже есть, то просто идёт привязка хранилища к PVC, если нет - хранилище создаётся (если используется динамическое создание).

Чтобы у каждого пода в деплое было своё хранилище, а не одно общее, используется kind: statefulSet - объект, как бы являющийся расширенной версией деплоя. Он создаёт более стабильные имена подов ${имя_statefulset}-${порядковый_номер}.${имя_сервиса}.${namespace}, чтобы подходить для систем со своей кластерной организацией, например, БД, которые не любят случайных часто меняющихся имён. StatefulSet также умеет создавать и PVC, которые привязываются к каждому задекларированному поду, создавая уникальные комбинации PVC-Pod. Порядок развёртывания в StatefulSet последовательный: поды создаются от меньшего номера к большему (1→2→3→4), а удаляются от большего к меньшему (4→3→2→1) - это также связано с кластерами БД (см. MariaDB Galera cluster). Перед развёртыванием все поды должны быть запущены или готовы (Running or Ready).

https://kube.academy/courses/kubernetes-core-concepts-part-4/lessons/lab-stateful-applications

Пример объекта StatefulSet

apiVersion: apps/v1 kind: StatefulSet metadata: name: gowebapp-mysql labels: app: gowebapp-mysql tier: backend spec: serviceName: gowebapp-mysql replicas: 1 selector: matchLabels: app: gowebapp-mysql tier: backend template: metadata: labels: app: gowebapp-mysql tier: backend spec: containers: - name: gowebapp-mysql env: - name: MYSQL_ROOT_PASSWORD value: mypassword image: gowebapp-mysql:v1 ports: - containerPort: 3306 livenessProbe: tcpSocket: port: 3306 initialDelaySeconds: 20 periodSeconds: 5 timeoutSeconds: 1 readinessProbe: exec: command: ["mysql", "-uroot", "-pmypassword", "-e", "use gowebapp; select count(*) from user"] initialDelaySeconds: 25 periodSeconds: 10 timeoutSeconds: 1 volumeMounts: - name: mysql-pv mountPath: /var/lib/mysql volumeClaimTemplates: - metadata: name: mysql-pv spec: accessModes: [ "ReadWriteOnce" ] resources: requests: storage: 5Gi

Динамическая конфигурация приложения

Когда что-то в конфигурации занесено жёстко и в явном виде, это потенциальный источник проблем. Для решения используется объект ConfigMaps, где перечислены настройки подов и на которые можно ссылаться

- как на переменные окружения - в разделе

spec.containersпода либо полностью (configMapRef:), либо дёргать оттуда ключи по отдельности (configMapKeyRef:) - как на том - том задаётся как configMap и в контейнере он монтируется по определённому пути. Также можно монтировать configMap как полностью, так и отдельные ключи.

Разница в подходах в том, что в случае переменных окружения надо перезапускать контейнер для изменения настроек, в то время как со смонтированным томом настройки в каталоге (там 2 файла) будут обновлены сразу же.

volumeMounts: - name: config-volume mountPath: '/opt/gowebapp/config' volumes: - name: config-volume configMap: name: gowebapp items: - key: webapp-config-json path: config.json

Секретные данные (kind: Secret) должны быть закодированы в Base64 и могут так же быть представлены подам, как и configMaps - в виде переменных или томов. Secret необязателен к использованию, если уже есть какой-то альтернативный способ хранения секретных данных.

kubectl create secret generic mysql --from-literal=password=mypassword

Потом в файле StatefulSet для mysql заменить

env: - name: MYSQL_ROOT_PASSWORD value: mypassword # на env: - name: MYSQL_ROOT_PASSWORD valueFrom: secretKeyRef: name: mysql key: password # в разделе readinessProbe: заменить пароль на переменную readinessProbe: exec: command: ["mysql", "-uroot", "-p${MYSQL_ROOT_PASSWORD}", "-e", "use gowebapp; select count(*) from user"]

Дополнительная нагрузка

Помимо сервисов, работающих, пока они не будут остановлены или не упадут сами, существуют задачи, которые должны работать временно. Это kind: Job. Они работают до получения результата, основаны на подах/контейнерах и будут пытаться выполнить задачу неограниченное кол-во раз (если не задано иное). Так как после подов и задач остаются логи, результаты их работы и т. п., админ решает, как чистить всё это, не k8s. Задачи бывают непараллельные (один под) и параллельные (несколько).

apiVersion: batch/v1 kind: Job metadata: name: pi spec: template: metadata: name: pi spec: securityContext: runAsUser: 1000 containers: - name: pi image: perl command: ["perl", "-Mbignum=bpi", "-wle", "print bpi(2000)"] restartPolicy: Never

Посмотреть результаты вышеописанного задания можно командой kubectl logs <pod-name>.

Параллельные задания с очередью (parallel jobs with a work queue) - запуск нескольких подов, каждый из которых берёт на себя часть очереди на обработку - как многопоточная обработка процессорными ядрами. Для этого типа задания нужно

- оставить

.spec.completionsнезаданным - каждый под должен иметь возможность проверить, пуста ли очередь и нужно ли выйти

- когда под завершил работу успешно, новый не создаётся

- когда хотя бы один под завершил работу успешно и остальные были уничтожены, задание также считается завершённым успешно

- когда любой под завершил работу успешно, остальные уже не должны ничего делать и также начинают завершать работу

apiVersion: batch/v1 kind: Job metadata: name: primes-parallel-wq labels: app: primes spec: parallelism: 3 template: metadata: name: primes labels: app: primes spec: securityContext: runAsUser: 1000 containers: - name: primes image: debian:stable-slim command: ["bash"] args: ["-c", "current=0; max=110; echo 1; echo 2; for((i=3;i<=max;)); do for((j=i-1;j>=2;)); do if [ `expr $i % $j` -ne 0 ] ; then current=1; else current=0; break; fi; j=`expr $j - 1`; done; if [ $current -eq 1 ] ; then echo $i; fi; i=`expr $i + 1`; done"] restartPolicy: Never

https://kubernetes.io/docs/tasks/job/fine-parallel-processing-work-queue/

Также существуют CronJobs - аналог cron в линуксе. Для каждого запуска создаётся новый job. Хранится 3 успешных и 1 неуспешный job. Jobs должны быть идемпотентными, т. е., их можно вызывать повторно для получения того же результата.

apiVersion: batch/v1beta1

kind: CronJob

metadata:

name: hello

spec:

schedule: "*/1 * * * *"

jobTemplate:

spec:

template:

spec:

securityContext:

runAsUser: 1000

containers:

- name: hello

image: busybox

args:

- /bin/sh

- -c

- date; echo Hello from the Kubernetes cluster

restartPolicy: OnFailure

DaemonSet - объект, следящий за тем, чтобы копия конкретного пода была запущена на всех хостах. Это нужно чаще всего для задач администрирования кластера, агентов логирования и мониторинга.

https://kube.academy/courses/kubernetes-core-concepts-part-5/lessons/lab-additional-workloads

Безопасность

https://kube.academy/courses/kubernetes-core-concepts-part-5/lessons/security

Объект NetworkPolicy задаёт, как группы подов могут соединяться друг с другом и с другими сетевыми конечными точками. Для выбора подов используются ярлыки и задаются правила, какой тип трафика разрешён на эти поды.

Изначально все поды внутри пространства имён могут обмениваться любым трафиком. Когда внутри пространства имён применяется сетевая политика, то поды, которые в ней выбраны, будут отбрасывать любые подключения, которые не указаны в политике. Остальные поды, не охваченные политикой, продолжат принимать любой трафик.

Пример политики:

apiVersion: networking.k8s.io/v1 kind: NetworkPolicy metadata: name: test-network-policy namespace:default spec: podSelector: matchLabels: tier: backend policyTypes: - Ingress - Egress

Правила Ingress-Egress, на которые идёт ссылка в политике. Логика: если несколько from: - то это логика И, если один с несколькими селекторами - ИЛИ. В данном случае «трафик из фронтенда проекта gowebapp». Egress - исходящий трафик, в данном случае вовне кластера на контроллер домена для аутентификации.

ingress: - from: - namespaceSelector: matchLabels: project: gowebapp - from: - podSelector: matchLabels: tier: frontend ports: - protocol: TCP port: 3306 egress: - to: - ipBlock: cidr: 10.0.0.0/24 ports: - protocol: TCP port: 389

SecurityContext - часть spec: пода, где описывается контекст безопасности, например, runAsUser/runAsGroup, SELinux, пути на ноде, которые могут быть смонтированы и т. д.

apiVersion: v1 kind: Pod metadata: name: myapp spec: securityContext: runAsUser: 1000 containers: - name: myapp image: myapp:v1 securityContext: allowPrivilegeEscalation: false - name: sidecar image: mysidecar:v1 securityContext: runAsUser: 2000

В примере выше runAsUser: на уровне контейнера переопределяет значение, заданное на уровне пода, применяемое ко всем контейнерам в нем.

Права доступа в кластере. Есть несколько способов аутентификации - клиентские сертификаты (используются для кластерных компонентов), токены (сервисные учётки), внешняя аутентификация (пользователи). Сервисные учётки создаются объектом ServiceAccount, и в кластере появляются файлы с описанием той учётки - принадлежность к пространству имён, URL API-сервера, какой сертификат и учётные данные нужно использовать, что избавляет от указания учётных данных в явном виде в приложении. Большинство клиентских библиотек Python, Java и т. п. смотрят в каталог кластера с сервисными учётными данными по умолчанию.

Ролевая модель доступа (RBAC). Строится на основе групп или ролей - kind: Role. Роль - это набор разрешений (правил). Есть стандартные роли - cluster-admin, admin, edit, view.

Пример RBAC, привязанный к пространству имён и позволяющий только get secrets.

kind: Role apiVersion: rbac.authorization.k8s.io/v1 metadata: namespace: default name: my-app-secret-reader rules: - apiGroups: [""] resources: ["secrets"] verbs: ["get"]

Есть также kind: ClusterRole - то же самое, но область действия - кластер в целом. Здесь позволены операции, перечисленные в verbs, только к подам с именами, перечисленными в resourceNames.

kind: ClusterRole apiVersion: rbac.authorization.k8s.io/v1 metadata: name: pod-reader rules: - apiGroups: [""] resources: ["pods"] verbs: ["get", "watch", "list"] resourceNames: ["nginx", "mariadb"]

Вывести список общекластерных ресурсов и привязанных к пространствам имён

kubectl api-resources --namespaced=false kubectl api-resources --namespaced=true

Роли привязываются к пользователям, группам и сервисным учёткам с помощью kind: RoleBinding (действие в рамках пространства имён). В рамках кластера kind: ClusterRoleBinding.

kind: RoleBinding apiVersion: rbac.authorization.k8s.io/v1 metadata: name: my-app-read-secret namespace: default subjects: - kind: ServiceAccount name: my-app apiGroup: rbac.authorization.k8s.io roleRef: kind: Role name: my-app-secret-reader apiGroup: rbac.authorization.k8s.io

Проверить возможность выполнять команды

kubectl auth can-i create deployments [--as user --namespace test] kubectl auth can-i delete nodes [--as user --namespace test]

Taints & tolerations

Политика запуска подов на хостах. Taints применяются к хостам, например, app=web, а tolerations - к подам. Разместиться на такой ноде с указанным тейнтом может только под, у которого соответствует настройка tolerations.

kubectl taint nodes node1 app=web:NoSchedule # убрать kubectl taint nodes node1 app=web:NoSchedule-

Эффект - как действовать, если под нетолерантен к указанному тейнту на хосте.

- NoSchedule - не размещать

- PreferNoSchedule - стараться не размещать

- NoExecute - не размещать и выгнать уже существующие

spec.tolerations в определении пода:

spec: tolerations: - key: "app" operator: "Equal" value: "web" effect: "NoSchedule"

Двойные кавычки в данном случае обязательны.

Taints & tolerations применяется на мастер-нодах, чтобы там не размещалась рабочая нагрузка - kubectl describe node <master> |grep Taint.

Taints & tolerations - это только средство ограничения. Если они настроены, то это не значит, что толерантные поды всегда будут размещаться на соответствующих хостах. Эти поды могут размещаться и на хостах, где нет ограничений. А для именно привязки к нодам нужен другой параметр - NodeAffinity.

Node selectors & affinity

Иногда нужно, чтобы под запускался на конкретном хосте, например, более производительном. Для этого нужно присвоить хосту ярлык

kubectl label nodes <nodename> <key=value>

и потом в spec.nodeSelector пода прописать соответствующий селектор.

Но если условия более сложные, например, запускаться на нескольких типах нод (OR) или запускаться на всех нодах, кроме указанных (NOT), тут вступает в действие spec.affinity в свойствах пода.

spec: affinity: nodeAffinity: requiredDuringSchedulingIgnoredDuringExecution: nodeSelectorTerms: - matchExpressions: - key: power operator: In values: - high - medium

- requiredDuringSchedulingIgnoredDuringExecution - не размещать новые, не трогать уже работающие

- preferredDuringSchedulingIgnoredDuringExecution - стараться не размещать новые, не трогать уже работающие

- requiredDuringSchedulingRequiredDuringExecution - сейчас такой опции нет, есть в планах - не размещать новые, выгонять работающие

https://kubernetes.io/docs/tasks/configure-pod-container/assign-pods-nodes-using-node-affinity/

Если настроено nodeAffinity, то это не гарантирует, что на этих хостах не будут размещаться другие поды. Чтобы гарантировать жёсткую привязку хостов и подов, нужно сочетать taints и affinities.

Static pods

В отсутствие мастер-ноды, kubelet на рабочей ноде остаётся наедине с собой, и взять инструкции, что ему запускать, неоткуда. Тем не менее, есть каталог, который он регулярно проверяет, куда можно положить манифесты подов. При изменении манифеста под перезапускается с соответствующими параметрами, при удалении - под удаляется. Кроме подов, ничего больше запустить нельзя, т. к. для этого нужны контроллеры на мастер-ноде.

Путь к каталогу манифестов задаётся параметром –pod-manifest-path=/etc/kubernetes/manifests как аргумент запуска kubelet.service (путь к каталогу может быть любым). Другой вариант - вписать в аргумент запуска –config=kubeconfig.yaml и задавать этот параметр уже в файле как staticPodPath: /etc/kubernetes/manifests.

Kubelet, будучи в кластере, запускает и статические, и распределённые на него кластером поды. С мастер-ноды видно все поды, в т. ч. и статические, но статические не могут быть изменены или удалены - для этого нужно работать с манифестами непосредственно на ноде. У статических подов имя родительского хоста прописано в конце их имени.

Статические поды нужны для работы компонентов мастер-хостов, таких как etcd, api и т. п. Они запускаются как поды, а если поды удаляются, то в соответствии с наличием манифестов в соответствующем каталоге, они запускаются вновь. См. пространство имён kube-system.

| Static PODs | DaemonSets |

|---|---|

| Создаются kubelet-ом непосредственно на узле | Создаётся сервером API (DaemonSet controller) |

| Пример применения: компоненты Control Plane | Пример применения: агенты мониторинга, логирования |

| Игнорируются Kube-scheduler-ом | |

Multiple schedulers

Помимо основного планировщика (или вместо него) можно установить дополнительные, указав имя при запуске аргументом –scheduler-name=. Или с помощью kubeadm, который запускает планировщик как под, описание которого будет в каталоге манифестов.

Чтобы запустить доп. планировщик, нужно скопировать исходный kube-scheduler.yaml и изменить его под свои нужды, добавив в spec.command параметр –scheduler-name=. Также, нужно настроить планировщика-лидера –leader-elect=true, если мастер-нод несколько. Также нужно настраивать –lock-object-name=<имя планировщика>leader-elect-resource-name=<имя планировщика>.

После настройки планировщика (его под должен быть в состоянии Running) его имя нужно указывать в spec.schedulerName пода, которому требуется использовать этот планировщик. При проблемах в работе планировщика состояние пода, который его использует, будет Pending.

Проверить, что за планировщик использовался для размещения пода, можно с помощью kubectl get events. Там будет SOURCE - имя планировщика, REASON - Scheduled и в сообщении будет написано об успешном размещении.

Логи самого планировщика (не забыть про namespace)

kubectl logs <scheduler name> -n kube-system

https://kubernetes.io/docs/tasks/extend-kubernetes/configure-multiple-schedulers/

Мониторинг и логирование

Есть ряд решений, как бесплатных (Metrics server, Prometheus, Elastic stack и т. д.), так и коммерческих (Datadog, Dynatrace и т. д.)

Metrics server (ранее Heapster) - ставится один на кластер. Собирает метрики с хостов и подов и хранит их только в памяти, на диск не пишет - т. е., историю не посмотреть. Схема работы такая: у kubelet на каждой ноде есть компонент cAdvisor, который через API передаёт данные на Metrics server.

Установить Metrics server

# в minikube minikube addons enable metrics-server # в microk8s microk8s enable metrics-server # для прочих git clone https://github.com/kubernetes-incubator/metrics-server.git kubectl create -f deploy/1.8+/

Через некоторое время будет доступна информация о производительности

kubectl top node kubectl top pod

Логи в k8s можно смотреть примерно так же, как и в докере:

kubectl logs -f <podName>

Но есть нюанс - если в поде несколько контейнеров, то нужно указывать имя контейнера после имени пода.

kubectl logs -f <podName> <containerName>

Команды и аргументы

# В Докере команда передаётся в момент непосредственного запуска, например docker run ubuntu sleep 5 # Чтобы указать команду в образе, используется формат CMD sleep 5 # shell command # или CMD ["sleep", "5"] # json format

Разница в том, что в случае с форматом json первый аргумент должен быть исполняемым (sleep). Также, в случае с json, в процессах не будет дополнительно висеть shell как среда запуска. Теперь, если построить образ, например, docker build -t sleeper ., то контейнер будет стартовать и через 5 сек завершать работу.

Изменить время с 5 сек на другое можно, запустив построенный образ: docker run sleeper sleep 10, но это неправильно, т. к. не использует встроенной в образ команды и повторяет её. Для этого вместо CMD используется

ENTRYPOINT ["sleep"]

В таком случае, образ можно запустить так: docker run sleeper 10, но в этом случае нужно всегда указывать значение в командной строке. Если просто запустить docker run sleeper, то будет ошибка, т. к. отсутствует необходимый аргумент. Чтобы задать значение по умолчанию, нужно добавить строку CMD к ENTRYPOINT:

ENTRYPOINT ["sleep"] CMD ["5"]

Тогда можно запускать просто docker run sleeper, и тогда будет всё по умолчанию, или docker run sleeper 10, что задаст своё значение. Можно даже при большом желании переопределить и саму команду: docker run –entrypoint ls sleeper / -lh

В k8s это пишется в spec.containers как

spec: containers: - name: sleeper image: sleeper command: ["ls"] args: ["/", "-lh"]

Т. е., command - это аналог ENTRYPOINT, а args - CMD.

Переменные

В ''spec.containers'' напрямую

spec: containers: - name: webapp-db env: - name: MYSQL_ROOT_PASSWORD value: mypassword

С помощью ConfigMap

ConfigMaps нужны для централизованного управления парами «ключ-значение», это хорошо помогает, когда много манифестов подов и замучаешься править их все по отдельности, лучше ссылаться оттуда на ConfigMap.

Создать ConfigMap можно, как и другие объекты в k8s, 2 способами: императивным (командой)

kubectl create configmap <name> --from-literal=key=value --from-literal=key2=value2 kubectl create configmap <name> --from-file=<path>

и декларативным, нарисовав соотв. файл (вместо раздела spec здесь data)

apiVersion: v1 kind: ConfigMap metadata: name: webapp-config data: APP_COLOR: red APP_MODE: test

и применив его. Посмотреть уже существующие - kubectl get/describe configmaps.

Как сослаться на ConfigMap в описании контейнера:

# целиком spec: containers: envFrom: - configMapRef: name: webapp-config # или только на значение env: - name: APP_COLOR valueFrom: configMapKeyRef: name: webapp-config key: APP_COLOR

Также, есть возможность использовать ConfigMap как volume:

volumes: - name: webapp-config-vol configMap: name: webapp-config

С помощью Secrets

Secrets нужны для хранения конфиденциальных данных. Это то же самое, что и ConfigMap, только данные там зашифрованы.

kubectl create secret generic <name> --from-literal=key=value --from-literal=key2=value2 kubectl create secret generic <name> --from-file=<path>

Описание объекта Secret для декларативного применения:

apiVersion: v1 kind: Secret metadata: name: webapp-secret data: DB_HOST: mysql DB_USER: root DB_PASSWORD: P@ssw0rd

Вопрос только в том, что для Secret нужно указывать данные не в plain text, а закодированным в base64.

echo -n "mysql" |base64 echo -n "root" |base64 echo -n "P@ssw0rd" |base64

Так что описание должно выглядеть так:

apiVersion: v1 kind: Secret metadata: name: webapp-secret data: DB_HOST: bXlzcWw= DB_USER: cm9vdA== DB_PASSWORD: UEBzc3cwcmQ=

Просмотр

kubectl get/describe secrets kubectl get secret <name> -o yaml

Раскодировать значения

echo -n "bXlzcWw=" |base64 -d echo -n "cm9vdA==" |base64 -d echo -n "UEBzc3cwcmQ=" |base64 -d

Как сослаться на Secret в описании контейнера

# целиком spec: containers: envFrom: - secretRef: name: webapp-secret # или только на значение env: - name: DB_PASSWORD valueFrom: secretKeyRef: name: webapp-secret key: DB_PASSWORD

Также, есть возможность использовать Secret как volume:

volumes: - name: webapp-secret-vol secret: secretName: webapp-secret

В этом случае в контейнере появляется каталог, где секреты лежат как файлы (здесь: DB_HOST, DB_USER, DB_PASSWORD) с содержимым в виде соответствующих ключей.

Особый секрет docker-registry для логина в приватный репозиторий Docker

kubectl create secret docker-registry docker-config-secret --docker-server=gitlab.example.com:5050 --docker-username=ВАШ_ЛОГИН --docker-password=ВАШ_ПАРОЛЬ --dry-run=client -o yaml > docker-config-secret.yaml

Обслуживание кластера

Когда хост становится недоступным, то, если он не вернулся в строй через 5 минут, кластер помечает его как умерший и запускает его поды на других хостах. Это называется pod eviction и регулируется менеджером контроллеров k8s kuber-controller-manager –pod-eviction-timeout=5m0s.

Если прошло меньше 5 минут, то поды заново запускаются на хосте. Нужно также помнить о том, что если под не управляется деплоем или репликой, то, в случае падения хоста и прошествии 5 минут этот под уже не запустится, когда хост вернётся, и нужно будет заново его создавать.

Чтобы выгнать нагрузку с хоста, есть команда kubectl drain <nodename>. Хост помечается как unschedulable, и даже когда хост возвращается в строй, он остаётся в том же статусе. DaemonSets, если они есть, не уйдут с ноды, поэтому при их наличии нужно добавлять параметр kubectl drain <nodename> –ignore-daemonsets.

Для возвращения его в работу нужно дать команду kubectl uncordon <nodename>.

Команда kubectl cordon <nodename> помечает ноду как unschedulable, но не выгоняет оттуда уже работающие поды, а лишь препятствует запуску на ней новых.

Обновление

Версия API-сервера не должна быть старее, чем любая версия прочих компонентов. Controller manager и Sheduler могут отставать по версии от API на одну минорную версию, а kubelet и kube-proxy - на две. Исключение - kubectl, который может быть как новее, так и старше на одну минорную версию, чем API.

Обновление поддерживается в пределах трёх минорных версий, например, если кластер работает на версии 1.10, то он может обновиться на 1.11 и 1.12, но не на 1.13. Рекомендуется обновляться последовательно по минорным версиям. В облаках обновление - это нажатие пары кнопок. В kubeadm - kubectl upgrade plan, kubectl upgrade apply. Если кластер собран вручную, то придётся обновлять все компоненты самостоятельно. Kubeadm обновляет все компоненты, кроме kubelet, который нужно обновлять самостоятельно на каждой ноде. Перед обновлением нужно обновить сам kubeadm, например, apt upgrade -y kubeadm=1.12.0-00.

Сначала нужно обновлять мастер-ноды (например, kubectl upgrade apply v1.12.0), потом - рабочие. Во время обновления мастера функции управления кластером недоступны, но рабочие ноды всё равно продолжают работать как обычно. Но если на рабочих нодах что-то упадёт, то подняться оно не сможет, т. к. нет управляющих компонентов.

Если после обновления мастер-ноды запустить kubectl get nodes, то в колонке VERSION покажется прежняя версия, потому что там отображается версия kubelet, которая ещё не была обновлена.

# Обновить kubelet apt upgrade -y kubelet=1.12.0-00 systemctl restart kubelet

После этого kubectl get nodes уже покажет новую версию на мастер-ноде.

Рабочие ноды можно обновить все сразу, но тогда будет простой. Можно обновлять рабочие ноды последовательно, предварительно освобождая их от нагрузки. Есть третий вариант - добавлять ноды с новой версией k8s в кластер, переезжать на них, а ноды со старой версией выводить из кластера. Примерный алгоритм действий на рабочей ноде

# на мастере kubectl drain <nodename> # на ноде apt upgrade -y kubeadm=1.12.0-00 apt upgrade -y kubelet=1.12.0-00 kubeadm upgrade node config --kubelet-version v1.12.0 systemctl restart kubelet # на мастере kubectl uncordon <nodename>

Резервное копирование

Бэкапить надо конфиги, ETCD-кластер и постоянные тома.

Рекомендуется использовать конфигурационные файлы и декларативный путь их применения. Даже если всё навернулось, с помощью конфигов можно быстро восстановить всё обратно. Есть способ и вытащить все созданные объекты в кластере, даже если кто-то ранее пользовался императивным способом создания объектов:

kubectl get all -A -o yaml > all-deploys.yaml

Тем не менее, это не охватывает все группы ресурсов кластера. Есть сторонние решения для резервного копирования через API типа Velero.

Вместо запросов к API можно делать резервную копию ETCD-кластера. В строке его запуска есть параметр –data-dir=/var/lib/etcd, указывающий на каталог с конфигурацией. ETCD умеет создавать снапшоты.

При всех командах к etcd нужно указывать данные для аутентификации

etcdctl snapshot save snapshot.db \ --endpoints=https://192.168.1.100:2379 \ # адрес кластера etcd (если etcd не локальный) --cacert=/etc/etcd/ca.crt \ # сертификат УЦ --cert=/etc/etcd/etcd-server.crt \ # сертификат кластера --key=/etc/etcd/etcd-server.key # ключ

# сделать снапшот etcdctl snapshot save snapshot.db # состояние снапшота etcdctl snapshot status snapshot.db # чтобы восстановить, нужно сначала остановить сервер API service kube-apiserver stop # а потом восстановить снапшот, указав НОВЫЙ каталог с конфигурацией ETCD etcdctl snapshot restore snapshot.db --data-dir=/var/lib/etcd-from-backup

Будет инициализирована новая конфигурация кластера и регистрация его членов как новых членов нового кластера, что препятствует их регистрации в старом кластере. Затем нужно прописать этот каталог в конфигурацию etcd.service. Далее

# перечитать конфиг сервисов systemctl daemon-reload # перезапустить etcd service etcd restart # запустить API service kube-apiserver start

Резервное копирование конфигурации ресурсов и ETCD имеют свои достоинства и недостатки, но в случае облаков, когда нет прямого доступа к etcd-кластеру, запросы к API для резервного копирования будут лучшим выбором.

Безопасность

Первая линия защиты - доступ к API.

- Кто может получать доступ (аутентификация)? Способы регулирования - имя и пароль/токен, сертификаты, внешний сервис типа LDAP и сервисные учётки для машин.

- Что может делать получивший доступ (авторизация)? Способы регулирования - RBAC, ABAC, Node authorization, Webhook mode.

В k8s нельзя завести учётки пользователей, но можно создать сервисные учётки - kubectl create serviceaccount <name>. Аутентификацией пользователей занимается сервер API перед обработкой запросов от них.

Статические файлы-списки с паролями или токенами

Самая простая форма. Это CSV, где перечислены учётные данные пользователей (пароль, имя, ID, группа).

password,user1,u0001,group1 password,user2,u0002,group2 password,user3,u0003,group1

Путь к этому файлу нужно прописать в аргументе запуска kube-apiserver –basic-auth-file=user-details.csv. Если использовать kubeadm, то тогда можно в описание статического пода spec.containers.command kube-apiserver.yaml прописать тот же аргумент. При сохранении изменений под автоматически перезапустится. Пример команды, использующей логин и пароль: curl -v -k https://master-node-ip:6443/api/v1/pods -u «user1:password».

Файл с токенами подобен парольному, просто вместо паролей там токены и аргумент другой - –token-auth-file=user-details.csv. Пример команды, использующей логин и токен: curl -v -k https://master-node-ip:6443/api/v1/pods –header «Authorization: Bearer weoih02939wfJfi393ruUr».

Статические файлы-списки не рекомендуются к использованию, т. к. учётные данные хранятся в открытом виде.

Сертификаты

Каждый компонент кластера подключается к другому по защищённому асимметричным шифрованием соединению, т. е., у каждого есть пара ключей (crt, key). Но, например, у API, который является и сервером, и клиентом (для ETCD и Kubelet) одновременно, может быть несколько пар ключей.

Над всем этим должен быть по меньшей мере один УЦ. Можно и второй для пары ETCD - API (как клиента ETCD). УЦ должен подписывать нижестоящие сертификаты.

Как создавать сертификаты

# CA key openssl genrsa -out ca.key 2048 # CA csr openssl req -new -key ca.key -subj "/CN=KUBERNETES-CA" -out ca.csr # CA crt (self-signed) openssl x509 -req -in ca.csr -signkey ca.key -out ca.crt # admin key openssl genrsa -out admin.key 2048 # admin csr (в subj нужно писать реальное имя аутентификации, и, например, добавить группу) openssl req -new -key admin.key -subj "/CN=kube-admin/O=system:masters" -out admin.csr # admin crt (ca signed) openssl x509 -req -in admin.csr -CA ca.crt -CAkey ca.key -out admin.crt # для системных компонентов к имени нужно добавить "SYSTEM:", например openssl req -new -key kube-scheduler.key -subj "/CN=system:kube-scheduler" -out kube-scheduler.csr openssl req -new -key kube-controller-manager.key -subj "/CN=system:kube-controller-manager" -out kube-controller-manager.csr # наконец, kube-proxy openssl req -new -key kube-proxy.key -subj "/CN=kube-proxy" -out kube-scheduler.csr # далее по аналогии # Использовать сертификат в запросе можно так: curl https://kube-apiserver:6443/api/v1/pods \ --key admin.key --cert admin.crt --cacert ca.crt

Другой способ - в файле конфигурации

- kube-config.yaml

apiVersion: v1 clusters: - cluster: certificate-authority: ca.crt server: https://kube-apiserver:6443 name: kubernetes kind: Config users: - name: kubernetes-admin user: client-certificate: admin.crt client-key: admin.key

Всем компонентам для проверки подлинности требуется указывать сертификат УЦ - он указывается в каждом клиенте и сервере.

Если ETCD-серверов несколько, то, помимо пары ключей etcdserver (–key-file=, –cert-file=) генерируется ещё одна - etcdpeer (–peer-key-file=, –peer-cert-file=) для соединения между членами ETCD-кластера.

Для API-сервера нужно добавлять все альтернативные имена, например,

kubernetes kubernetes.default kubernetes.default.svc kubernetes.default.svc.cluster.local

У каждого кублета на нодах тоже должен быть свой сертификат, названный по имени ноды. Так как ноды являются частью системы, то имена в сертификатах должны быть типа system:node:node01, system:node:node02, system:node:node03 и т. д. Также, группа должна быть system:nodes. Прописываются сертификаты в конфигурациях кублетов, естественно, с упоминанием сертификата УЦ.

Как проверить сертификаты

# Если k8s установлен вручную и работает как сервисы, то поиск строчек запуска (для поиска местоположения сертификатов) нужно делать в сервисах. cat /etc/systemd/system/kube-apiserver.service # и смотреть в логи нужно соответственно journalctl -u etcd.service -l # Если же он установлен с помощью kubeadm, то k8s крутится на статических подах и нужно смотреть строчки запуска там. cat /etc/kubernetes/manifests/kube-apiserver.yaml # логи kubectl logs etcd-master # если нет возможности посмотреть логи через kubectl, тогда через докер docker ps -a docker logs <container name>

Создаётся табличка с заголовками типа Component, Type, Cert path, CN, ALT, Org, Issuer, Expiration. Дальше просматриваются свойства сертификатов, и табличка заполняется.

openssl x509 -in /etc/kubernetes/pki/apiserver.crt -text -noout

Certificate API

В Кубере есть инструмент подписи сертификатов, находящийся в Controller manager. По сути, УЦ в Кубере - это просто пара ключей, и они должны храниться в максимально безопасном месте, обычно на мастер-ноде, которая в этом случае является сервером УЦ. Для облегчения работы с сертификатами есть соответствующий API.

Теперь, вместо того, чтобы залезать на мастер-ноду и руками подписывать сертификат, создаётся объект CertificateSigningRequest, который позволяет удобно работать с запросами.

- Пользователь создаёт ключ и запрос, и отправляет запрос админу.

- Админ создаёт CertificateSigningRequest, вбивая в

spec.requestсодержимое файла запроса, закодированное в base64 (например,cat user.csr |base64). - Теперь запрос можно увидеть, набрав команду

kubectl get csr, а одобрить -kubectl certificate approve <name>.

Вывести содержимое полученного объекта - kubectl get csr user -o yaml. Из раздела status.certificate можно скопировать значение и, раскодировав его из base64, получить подписанный сертификат. echo "YfbuE..=03" |base64 -d > user.crt

KubeConfig

Так как на любую команду, если использовать сертификаты для аутентификации, придётся добавлять параметры, указывающие на эти сертификаты, например curl https://kube-apiserver:6443/api/v1/pods –key admin.key –cert admin.crt –cacert ca.crt, есть более удобный способ прописать эти учётные данные в конфигурационный файл ~/.kube/config.

Этот файл имеет 3 секции - Clusters (перечислены кластеры), Contexts, Users (перечислены учётки). Контекст - это объединение кластеров и пользователей: кто к каким кластерам подключается. В контексте сертификатов сертификат УЦ прописывается в кластерном разделе, а пользовательская пара ключей - в пользовательском.

Контекст по умолчанию прописывается в том же файле current-context: userName@clusterName.

Вывести текущий конфиг: kubectl config view. Можно указать путь к конфигу с помощью параметра –kubeconfig=/path/customconf.

Изменить контекст в конфиге: kubectl config use-context userName@clusterName.

Помимо самого кластера, в конфиге можно указать и пространство имён для подключения параметром namespace: <namespaceName> в contexts.name.context.

Можно вместо прописывания пути к файлу (certificate-authority: /etc/kubernetes/pki/ca.crt) прописать закодированное в base64 содержимое этого файла (certificate-authority-data: LKE0I3rH…*h3+=)

Сервисные учётки

Нужны для работы приложений с Кубером, например, Prometheus (получение метрик) или Jenkins (создание объектов).

kubectl create serviceaccount <name> kubectl get serviceaccount

Сервисная учётка автоматически создаётся с токеном, использующимся для аутентификации. Токен хранится как связанный с этой учёткой Secret.

Стандартно в каждом пространстве имён существует сервисная учётка default, которая автоматически предоставляется подам через смонтированный том, давая доступ к API. Если сервисная учётка нужна другая, её можно указать с описании пода в разделе spec - serviceAccount: name-sa.

Если под создан отдельно, то для изменения сервисной учётки в нём нужно удалить его и создать заново. В деплое это делается автоматически при изменении описания пода в нём.

Если явно не указана сервисная учётка в описании пода, то автоматически монтируется default. Чтобы отключить это, в spec нужно прописать automountServiceAccountToken: false.

Защита образов

В описании контейнера есть имя образа, например, image: nginx. По факту, это image: docker.io/nginx/nginx, т. е., если не указано, то пользователь/учётка подставляется исходя из имени образа/репозитория, а реестр образов по умолчанию это Docker Hub (docker.io). Реестр образов кубера - Google Registry (gcr.io).

Если репозиторий приватный, то в Докере нужно сначала зайти в него, а потом уже запускать контейнеры из его образов, например,

# логин и пароль указываются в интерактивном режиме docker login private-repo.io docker run private-repo.io/apps/app

В Кубере, чтобы указать учётные данные для образа из приватного репозитория, указанного в image:, нужно сослаться на Secret типа docker-registry.

kubectl create secret docker-registry <secret name> \ --docker-server= --docker-username= --docker-password= --docker-email=

spec: containers: - name: app image: private-repo.io/apps/app imagePullSecrets: - name: <secret name>

securityContext

В Докере при запуске контейнера можно указывать разные опции безопасности, например

docker run --user=1000 ubuntu sleep 5000 docker run --cap-add NET_ADMIN ubuntu

В Кубере, так как контейнеры запускаются внутри подов, опции могут указываться на уровне подов, что повлияет на все контейнеры внутри, и на уровне контейнера. Опция в контейнере перекрывает опцию пода, если она задана и там, и там.

apiVersion: v1 kind: Pod metadata: name: app spec: securityContext: runAsUser: 1000 containers: - name: app image: ubuntu command: ["sleep", "5000"] securityContext: runAsUser: 1000 capabilities: add: ["NET_ADMIN"]

В данном случае, capabilities на уровне пода не поддерживаются.

Сетевые политики

Не все сетевые решения для k8s поддерживают сетевые политики, например, Kube-router, Calico, Romana, Weave-net - поддерживают, а Flannel - нет.

- Ingress - входящий трафик

- Egress - исходящий трафик

Всем подам по умолчанию разрешён любой трафик. К примеру, если приложение состоит из веб-части, api и БД, то веб-часть может слать трафик напрямую к БД, что нежелательно. Поэтому можно нарисовать сетевую политику, которая разрешает определённый трафик с определённых подов. В данном случае, нужно сделать политику для пода БД, которая разрешает Ingress-трафик на порт 3306 c пода API.

Привязка политики к поду делается так же, как и реплик с сервисами - через ярлыки и селекторы.

apiVersion: networking.k8s.io/v1 kind: NetworkPolicy metadata: name: db-policy spec: # применяется к подам с ярлыком role: db podSelector: matchLabels: role: db policyTypes: - Ingress - Egress ingress: # разрешить трафик с подов с ярлыком name: api-pod - from: - podSelector: matchLabels: name: api-pod # только для подов из пространства имён с ярлыком name: prod # не забыть прописать сначала этот ярлык для пространства имён namespaceSelector: matchLabels: name: prod # разрешить подключаться внешнему серверу - ipBlock: cidr: 192.168.1.10/32 ports: - protocol: TCP port: 3306 egress: # разрешить исходящий трафик на сервер по порту 80 - to: - ipBlock: cidr: 192.168.1.20/32 ports: - protocol: TCP port: 80

Если убрать podSelector и оставить namespaceSelector, то все поды в определённом пространстве имён смогут подключаться к поду БД.

Логика в spec.ingress.from: все объекты в списке (начинающиеся на -) - ИЛИ, пункты внутри списка - И. То есть, в примере выше - podSelector И namespaceSelector. Если написать - namespaceSelector, то будет podSelector ИЛИ namespaceSelector, что совершенно изменит логику.

Далее нужно применить политику.

MicroK8S

https://microk8s.io/

https://microk8s.io/docs

# install snap install microk8s --classic # install add-ons microk8s.enable dashboard dns ingress registry # status, info microk8s status microk8s kubectl get all microk8s kubectl get nodes microk8s kubectl get services microk8s.kubectl cluster-info microk8s.kubectl get po --all-namespaces # добавить юзера в группу sudo usermod -a -G microk8s <user> sudo chown -f -R <user> ~/.kube newgrp microk8s # затем перезайти в систему # Прописать алиас, чтобы не набирать бесконечное "microk8s kubectl" echo "alias kubectl='microk8s kubectl'" >> .bash_aliases echo "alias k='microk8s kubectl'" >> .bash_aliases # Для того, чтобы автокомплит работал с алиасом source <(kubectl completion bash) >> ~/.bashrc source <(kubectl completion bash | sed s/kubectl/k/g) >> ~/.bashrc

https://kubernetes.io/docs/reference/kubectl/cheatsheet/#bash

Alias & auto-completion: https://kubernetes.io/docs/tasks/tools/included/optional-kubectl-configs-bash-linux/

Получить доступ к панели мониторинга

Геморрой начался с самого начала. Приборная панель ставится и включается без проблем, но зайти на неё можно только с localhost «по соображениям безопасности».

microk8s.kubectl -n kube-system edit service kubernetes-dashboard # Заменить type: clusterIP # на type: NodePort # Узнать порт microk8s.kubectl -n kube-system get services NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE dashboard-metrics-scraper ClusterIP 10.152.183.107 <none> 8000/TCP 46m kube-dns ClusterIP 10.152.183.10 <none> 53/UDP,53/TCP,9153/TCP 46m kubernetes-dashboard NodePort 10.152.183.79 <none> 443:31315/TCP 46m metrics-server ClusterIP 10.152.183.235 <none> 443/TCP 46m

Теперь можно заходить по https://, адресу ноды и, в данном случае, порту 31315.

Узнать токен входа:

token=$(microk8s kubectl -n kube-system get secret | grep default-token | cut -d " " -f1) microk8s kubectl -n kube-system describe secret $token

https://www.thegeekdiary.com/how-to-access-kubernetes-dashboard-externally/

https://microk8s.io/docs/addon-dashboard

Кластер

# На будущей мастер-ноде выполнить microk8s.add-node # Полученную ссылку запустить на будущей подчинённой ноде

Развёртывание приложения

# Название, образ kubectl create deployment kubernetes-bootcamp --image=gcr.io/google-samples/kubernetes-bootcamp:v1 # Публикация - прокси даёт доступ с локального хоста и работает, пока его не остановят (надо запускать в отдельном окне) kubectl proxy # проверка curl http://localhost:8001/version

Поды, узлы

Под - из чего состоит приложение: контейнеры и ресурсы (хранилище, сеть, конфиги). Все контейнеры в поде имеют один и тот же IP-адрес (адреса?) и пространство портов, выполняющиеся в общем контексте на одном и том же узле.

Узел - рабочая машина, виртуальная или физическая. Каждый узел управляется мастером (ведущим узлом). Узел может содержать несколько подов, которые мастер Kubernetes автоматически размещает на разные узлы кластера. Ведущий узел при автоматическом планировании (распределении подов по узлам) учитывает доступные ресурсы на каждом узле.

В каждом узле Kubernetes как минимум работает:

- Kubelet — процесс, отвечающий за взаимодействие между мастером Kubernetes и узлом; он управляет подами и запущенными контейнерами на рабочей машине.

- Среда выполнения контейнера (например, Docker или rkt), отвечающая за получение (загрузку) образа контейнера из реестра, распаковку контейнера и запуск приложения.

Наиболее распространенные операции:

- kubectl get — вывод списка ресурсов

- kubectl describe — вывод подробной информации о ресурсе

- kubectl logs — вывод логов контейнера в поде

- kubectl exec — выполнение команды в контейнере пода

Перечисленные выше команды можно использовать, чтобы узнать, когда и где приложения были развернуты, их текущее состояние и конфигурацию.

Создание сервиса для открытия доступа к приложению

Под - расходный материал, они создаются и уничтожаются, а механизм ReplicaSet следит, чтобы поддерживалось заданное их количество.

Сервисы - логическое объединение подов.

Публикация сервиса

root@vmls-k8s1:~# kubectl get services NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.152.183.1 <none> 443/TCP 2d1h root@vmls-k8s1:~# kubectl expose deployment/kubernetes-bootcamp --type="NodePort" --port 8080 service/kubernetes-bootcamp exposed root@vmls-k8s1:~# kubectl get services NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.152.183.1 <none> 443/TCP 2d1h kubernetes-bootcamp NodePort 10.152.183.216 <none> 8080:31689/TCP 52s root@vmls-k8s1:~# kubectl describe services/kubernetes-bootcamp Name: kubernetes-bootcamp Namespace: default Labels: app=kubernetes-bootcamp Annotations: <none> Selector: app=kubernetes-bootcamp Type: NodePort IP: 10.152.183.216 Port: <unset> 8080/TCP TargetPort: 8080/TCP NodePort: <unset> 31689/TCP Endpoints: 10.1.17.2:8080 Session Affinity: None External Traffic Policy: Cluster Events: <none>

Ярлыки (labels)

# Узнать имена ярлыков root@vmls-k8s1:~# kubectl describe deployment Name: kubernetes-bootcamp Namespace: default CreationTimestamp: Mon, 17 Aug 2020 12:04:21 +0000 Labels: app=kubernetes-bootcamp Annotations: deployment.kubernetes.io/revision: 1 Selector: app=kubernetes-bootcamp Replicas: 1 desired | 1 updated | 1 total | 1 available | 0 unavailable StrategyType: RollingUpdate MinReadySeconds: 0 RollingUpdateStrategy: 25% max unavailable, 25% max surge Pod Template: Labels: app=kubernetes-bootcamp Containers: kubernetes-bootcamp: Image: gcr.io/google-samples/kubernetes-bootcamp:v1 Port: <none> Host Port: <none> Environment: <none> Mounts: <none> Volumes: <none> Conditions: Type Status Reason ---- ------ ------ Available True MinimumReplicasAvailable Progressing True NewReplicaSetAvailable OldReplicaSets: <none> NewReplicaSet: kubernetes-bootcamp-6f6656d949 (1/1 replicas created) Events: <none> # Запрос подов по имени ярлыка root@vmls-k8s1:~# kubectl get pods -l app=kubernetes-bootcamp NAME READY STATUS RESTARTS AGE kubernetes-bootcamp-6f6656d949-btv4z 1/1 Running 0 46h # Запрос сервисов по имени ярлыка root@vmls-k8s1:~# kubectl get services -l app=kubernetes-bootcamp NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes-bootcamp NodePort 10.152.183.216 <none> 8080:31689/TCP 79m # Задать новый ярлык root@vmls-k8s1:~# kubectl label pod kubernetes-bootcamp-6f6656d949-btv4z app=v1 --overwrite pod/kubernetes-bootcamp-6f6656d949-btv4z labeled # Запрос подов, где виден новый ярлык root@vmls-k8s1:~# kubectl describe pods kubernetes-bootcamp-6f6656d949-btv4z Name: kubernetes-bootcamp-6f6656d949-btv4z Namespace: default Priority: 0 Node: 10.1.0.223/10.1.0.223 Start Time: Mon, 17 Aug 2020 12:04:21 +0000 Labels: app=v1 pod-template-hash=6f6656d949 Annotations: <none> Status: Running IP: 10.1.17.2 IPs: IP: 10.1.17.2 Containers: kubernetes-bootcamp: Container ID: containerd://215ec311ea17ae5b923d93be3391c4b190cf29349b4173c7d0d1790e340c4f25 Image: gcr.io/google-samples/kubernetes-bootcamp:v1 Image ID: gcr.io/google-samples/kubernetes-bootcamp@sha256:0d6b8ee63bb57c5f5b6156f446b3bc3b3c143d233037f3a2f00e279c8fcc64af Port: <none> Host Port: <none> State: Running Started: Mon, 17 Aug 2020 12:04:49 +0000 Ready: True Restart Count: 0 Environment: <none> Mounts: /var/run/secrets/kubernetes.io/serviceaccount from default-token-gzgxh (ro) Conditions: Type Status Initialized True Ready True ContainersReady True PodScheduled True Volumes: default-token-gzgxh: Type: Secret (a volume populated by a Secret) SecretName: default-token-gzgxh Optional: false QoS Class: BestEffort Node-Selectors: <none> Tolerations: node.kubernetes.io/not-ready:NoExecute for 300s node.kubernetes.io/unreachable:NoExecute for 300s Events: <none> # Запрос подов с новым ярлыком root@vmls-k8s1:~# kubectl get pods -l app=v1 NAME READY STATUS RESTARTS AGE kubernetes-bootcamp-6f6656d949-btv4z 1/1 Running 0 46h

Удаление сервиса

root@vmls-k8s1:~# kubectl delete service -l app=kubernetes-bootcamp service "kubernetes-bootcamp" deleted # Убедиться, что сервиса нет root@vmls-k8s1:~# kubectl get services NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.152.183.1 <none> 443/TCP 2d3h # и что он недоступен root@vmls-k8s1:~# curl localhost:$NODE_PORT curl: (7) Failed to connect to localhost port 31689: Connection refused # в то время под живой и как изнутри него всё работает root@vmls-k8s1:~# kubectl exec kubernetes-bootcamp-6f6656d949-btv4z -- curl localhost:8080 % Total % Received % Xferd Average Speed Time Time Time Current Dload Upload Total Spent Left Speed 100 84 0 84 0 0 15587 0 --:--:-- --:--:-- --:--:-- 16800 Hello Kubernetes bootcamp! | Running on: kubernetes-bootcamp-6f6656d949-btv4z | v=1

https://kubernetes.io/ru/docs/tutorials/kubernetes-basics/expose/

Масштабирование

В случае масштабирования развёртывания создаются новые поды, которые распределяются по узлам с доступными ресурсами. У сервисов есть встроенный балансировщик нагрузки, который распределяет сетевой трафик всех подов в открытом извне развертывании.

# Под пока 1 root@vmls-k8s1:~# kubectl get deployments NAME READY UP-TO-DATE AVAILABLE AGE kubernetes-bootcamp 1/1 1 1 2d # Посмотреть ReplicaSet root@vmls-k8s1:~# kubectl get rs NAME DESIRED CURRENT READY AGE kubernetes-bootcamp-6f6656d949 1 1 1 2d # Размножить root@vmls-k8s1:~# kubectl scale deployments/kubernetes-bootcamp --replicas=4 deployment.apps/kubernetes-bootcamp scaled # Теперь подов 4 root@vmls-k8s1:~# kubectl get deployments NAME READY UP-TO-DATE AVAILABLE AGE kubernetes-bootcamp 4/4 4 4 2d root@vmls-k8s1:~# kubectl get pods -o wide NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES kubernetes-bootcamp-6f6656d949-2k99k 1/1 Running 0 82s 10.1.17.4 10.1.0.223 <none> <none> kubernetes-bootcamp-6f6656d949-52l9m 1/1 Running 0 82s 10.1.35.3 10.1.0.222 <none> <none> kubernetes-bootcamp-6f6656d949-btv4z 1/1 Running 0 2d 10.1.17.2 10.1.0.223 <none> <none> kubernetes-bootcamp-6f6656d949-lhnkd 1/1 Running 0 83s 10.1.17.3 10.1.0.223 <none> <none> # В логах есть отражение этого факта root@vmls-k8s1:~# kubectl describe deployments/kubernetes-bootcamp Name: kubernetes-bootcamp Namespace: default CreationTimestamp: Mon, 17 Aug 2020 12:04:21 +0000 Labels: app=kubernetes-bootcamp Annotations: deployment.kubernetes.io/revision: 1 Selector: app=kubernetes-bootcamp Replicas: 4 desired | 4 updated | 4 total | 4 available | 0 unavailable StrategyType: RollingUpdate MinReadySeconds: 0 RollingUpdateStrategy: 25% max unavailable, 25% max surge Pod Template: Labels: app=kubernetes-bootcamp Containers: kubernetes-bootcamp: Image: gcr.io/google-samples/kubernetes-bootcamp:v1 Port: <none> Host Port: <none> Environment: <none> Mounts: <none> Volumes: <none> Conditions: Type Status Reason ---- ------ ------ Progressing True NewReplicaSetAvailable Available True MinimumReplicasAvailable OldReplicaSets: <none> NewReplicaSet: kubernetes-bootcamp-6f6656d949 (4/4 replicas created) Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal ScalingReplicaSet 3m7s deployment-controller Scaled up replica set kubernetes-bootcamp-6f6656d949 to 4

Балансировка

# Смотрим свойства сервиса - порт ноды root@vmls-k8s1:~# kubectl describe services/kubernetes-bootcamp Name: kubernetes-bootcamp Namespace: default Labels: app=kubernetes-bootcamp Annotations: <none> Selector: app=kubernetes-bootcamp Type: NodePort IP: 10.152.183.74 Port: <unset> 8080/TCP TargetPort: 8080/TCP NodePort: <unset> 31386/TCP Endpoints: 10.1.17.3:8080,10.1.17.4:8080,10.1.35.2:8080 + 1 more... Session Affinity: None External Traffic Policy: Cluster Events: <none> # Теперь при каждом запросе они идут в разные поды root@vmls-k8s1:~# curl localhost:31386 Hello Kubernetes bootcamp! | Running on: kubernetes-bootcamp-6f6656d949-rztf4 | v=1 root@vmls-k8s1:~# curl localhost:31386 Hello Kubernetes bootcamp! | Running on: kubernetes-bootcamp-6f6656d949-lhnkd | v=1 root@vmls-k8s1:~# curl localhost:31386 Hello Kubernetes bootcamp! | Running on: kubernetes-bootcamp-6f6656d949-52l9m | v=1

Свёртывание масштабирования

root@vmls-k8s1:~# kubectl scale deployments/kubernetes-bootcamp --replicas=2 deployment.apps/kubernetes-bootcamp scaled root@vmls-k8s1:~# kubectl get deployments NAME READY UP-TO-DATE AVAILABLE AGE kubernetes-bootcamp 2/2 2 2 2d1h root@vmls-k8s1:~# kubectl get pods -o wide NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES kubernetes-bootcamp-6f6656d949-glxgv 1/1 Terminating 0 67s 10.1.35.4 10.1.0.222 <none> <none> kubernetes-bootcamp-6f6656d949-lhnkd 1/1 Running 0 20m 10.1.17.3 10.1.0.223 <none> <none> kubernetes-bootcamp-6f6656d949-qmct2 1/1 Running 0 67s 10.1.60.8 vmls-k8s1 <none> <none> kubernetes-bootcamp-6f6656d949-rztf4 1/1 Terminating 0 122m 10.1.35.2 10.1.0.222 <none> <none>

https://kubernetes.io/ru/docs/tutorials/kubernetes-basics/scale/scale-intro/

Плавающие обновления (rolling updates)

Плавающие обновления позволяют обновить развёртывания без простоев, шаг за шагом заменяя старые поды на новые. Новые поды будут запущены на узлах, имеющих достаточно ресурсов.

В предыдущем модуле мы промасштабировали приложение до нескольких экземпляров. Это необходимо сделать, чтобы иметь возможность обновлять приложение, не влияя на его доступность. По умолчанию, максимальное количество подов, которое может быть недоступно во время обновления, и максимальное количество новых подов, которое можно создать, равны 1. Эти две опции могут быть определены в абсолютном (числа) или относительном соотношении (проценты). В Kubernetes обновления версионируются, поэтому любое обновление развёртывания можно откатить до предыдущей (стабильной) версии.

Балансировщик будет работать только для доступных подов.

# Список развёртываний root@vmls-k8s1:~# kubectl get deployments NAME READY UP-TO-DATE AVAILABLE AGE kubernetes-bootcamp 4/4 4 4 2d1h # Список подов root@vmls-k8s1:~# kubectl get pods NAME READY STATUS RESTARTS AGE kubernetes-bootcamp-6f6656d949-lhnkd 1/1 Running 0 35m kubernetes-bootcamp-6f6656d949-qhlcg 1/1 Running 0 17s kubernetes-bootcamp-6f6656d949-qmct2 1/1 Running 0 16m kubernetes-bootcamp-6f6656d949-rvflg 1/1 Running 0 17s # Описание подов (о версии см. строку Image) root@vmls-k8s1:~# kubectl describe pods Name: kubernetes-bootcamp-6f6656d949-lhnkd Namespace: default Priority: 0 Node: 10.1.0.223/10.1.0.223 Start Time: Wed, 19 Aug 2020 12:45:51 +0000 Labels: app=kubernetes-bootcamp pod-template-hash=6f6656d949 Annotations: <none> Status: Running IP: 10.1.17.3 IPs: IP: 10.1.17.3 Controlled By: ReplicaSet/kubernetes-bootcamp-6f6656d949 Containers: kubernetes-bootcamp: Container ID: containerd://3feba85a18a3e9306cd5d5d9dcb29be8fa7c173b4bb1c907449634e2437c23fc Image: gcr.io/google-samples/kubernetes-bootcamp:v1 # дальнейшая простыня обрезана # Обновить до v2 root@vmls-k8s1:~# kubectl set image deployments/kubernetes-bootcamp kubernetes-bootcamp=jocatalin/kubernetes-bootcamp:v2 deployment.apps/kubernetes-bootcamp image updated # Старые поды убиваются, создаются новые свежей версии root@vmls-k8s1:~# kubectl get pods NAME READY STATUS RESTARTS AGE kubernetes-bootcamp-6f6656d949-lhnkd 1/1 Terminating 0 39m kubernetes-bootcamp-6f6656d949-qhlcg 1/1 Terminating 0 4m2s kubernetes-bootcamp-6f6656d949-qmct2 1/1 Terminating 0 20m kubernetes-bootcamp-6f6656d949-rvflg 1/1 Terminating 0 4m2s kubernetes-bootcamp-86656bc875-5hmdv 1/1 Running 0 28s kubernetes-bootcamp-86656bc875-5pj79 1/1 Running 0 17s kubernetes-bootcamp-86656bc875-c8mpt 1/1 Running 0 17s kubernetes-bootcamp-86656bc875-s75z4 1/1 Running 0 27s

Проверка

# Узнаём порт для подключения root@vmls-k8s1:~# kubectl describe services/kubernetes-bootcamp Name: kubernetes-bootcamp Namespace: default Labels: app=kubernetes-bootcamp Annotations: <none> Selector: app=kubernetes-bootcamp Type: NodePort IP: 10.152.183.74 Port: <unset> 8080/TCP TargetPort: 8080/TCP NodePort: <unset> 31386/TCP Endpoints: 10.1.17.6:8080,10.1.17.7:8080,10.1.35.6:8080 + 1 more... Session Affinity: None External Traffic Policy: Cluster Events: Type Reason Age From Message ---- ------ ---- ---- ------- Warning FailedToUpdateEndpointSlices 4m46s endpoint-slice-controller Error updating Endpoint Slices for Service default/kubernetes-bootcamp: Error updating kubernetes-bootcamp-xpgkx EndpointSlice for Service default/kubernetes-bootcamp: Operation cannot be fulfilled on endpointslices.discovery.k8s.io "kubernetes-bootcamp-xpgkx": the object has been modified; please apply your changes to the latest version and try again # Проверка запросом, видно, что версия 2 root@vmls-k8s1:~# curl localhost:31386 Hello Kubernetes bootcamp! | Running on: kubernetes-bootcamp-86656bc875-s75z4 | v=2 # Ещё один способ проверить root@vmls-k8s1:~# kubectl rollout status deployments/kubernetes-bootcamp deployment "kubernetes-bootcamp" successfully rolled out # Проверка версии Image подов root@vmls-k8s1:~# kubectl describe pods Name: kubernetes-bootcamp-86656bc875-5hmdv Namespace: default Priority: 0 Node: 10.1.0.222/10.1.0.222 Start Time: Wed, 19 Aug 2020 13:24:47 +0000 Labels: app=kubernetes-bootcamp pod-template-hash=86656bc875 Annotations: <none> Status: Running IP: 10.1.35.6 IPs: IP: 10.1.35.6 Controlled By: ReplicaSet/kubernetes-bootcamp-86656bc875 Containers: kubernetes-bootcamp: Container ID: containerd://d4c020babb066f3eb28f002cf96370f3b5bfdc5f3edc34dca76bb2a300e9f326 Image: jocatalin/kubernetes-bootcamp:v2 # дальнейшая простыня обрезана

Откат обновления

# Проба обновиться до версии 10 root@vmls-k8s1:~# kubectl set image deployments/kubernetes-bootcamp kubernetes-bootcamp=gcr.io/google-samples/kubernetes-bootcamp:v10 deployment.apps/kubernetes-bootcamp image updated # Проверяем - обновление не прошло root@vmls-k8s1:~# kubectl get deployments NAME READY UP-TO-DATE AVAILABLE AGE kubernetes-bootcamp 3/4 2 3 2d1h root@vmls-k8s1:~# kubectl get pods NAME READY STATUS RESTARTS AGE kubernetes-bootcamp-64468f5bc5-p8zb6 0/1 ErrImagePull 0 56s kubernetes-bootcamp-64468f5bc5-s2btt 0/1 ErrImagePull 0 56s kubernetes-bootcamp-86656bc875-5hmdv 1/1 Running 0 13m kubernetes-bootcamp-86656bc875-c8mpt 1/1 Running 0 13m kubernetes-bootcamp-86656bc875-s75z4 1/1 Running 0 13m # Если запустить root@vmls-k8s1:~# kubectl describe pods # , то будет ясно, что такой версии нет # Откатываем назад, к предыдущей рабочей версии root@vmls-k8s1:~# kubectl rollout undo deployments/kubernetes-bootcamp deployment.apps/kubernetes-bootcamp rolled back # Всё снова в порядке root@vmls-k8s1:~# kubectl get pods NAME READY STATUS RESTARTS AGE kubernetes-bootcamp-86656bc875-5hmdv 1/1 Running 0 14m kubernetes-bootcamp-86656bc875-786cb 1/1 Running 0 28s kubernetes-bootcamp-86656bc875-c8mpt 1/1 Running 0 14m kubernetes-bootcamp-86656bc875-s75z4 1/1 Running 0 14m # В строке Image будет видно, что опять развёрнута v2 root@vmls-k8s1:~# kubectl describe pods

https://kubernetes.io/ru/docs/tutorials/kubernetes-basics/update/update-intro/

LinuxFoundationX: Introduction to Kubernetes